IA et PROMT : L'art du prompt est comme une danse avec l'intelligence artificielle

J’ai testé (et retesté) ChatGPT (OpenAI), Claude (Anthropic) et Gemini (Google).

Chaque IA a son petit talent :

- Une polémique politique bien sentie ? Grok adore ça.

- Besoin d’une image gratuite en un clin d’œil ? Copilot fait le taf.

- Un océan de documents à traiter ? AI Studio se débrouille pas mal.

Bref, tout dépend du contexte !

Et puis, il y a les fameux Artefacts de Claude (le nouveau Canvas dans ChatGPT-4o et Gemini). Un vrai game-changer ! Imaginez : un chat à gauche, et à droite, un « Artefact » (ou Canvas) qui s’adapte à ce que vous faites. Un doc Word/PDF pour du texte, un éditeur de code pour les développeurs… C’est comme avoir un assistant multitâche qui ne râle jamais (contrairement à un collègue humain).

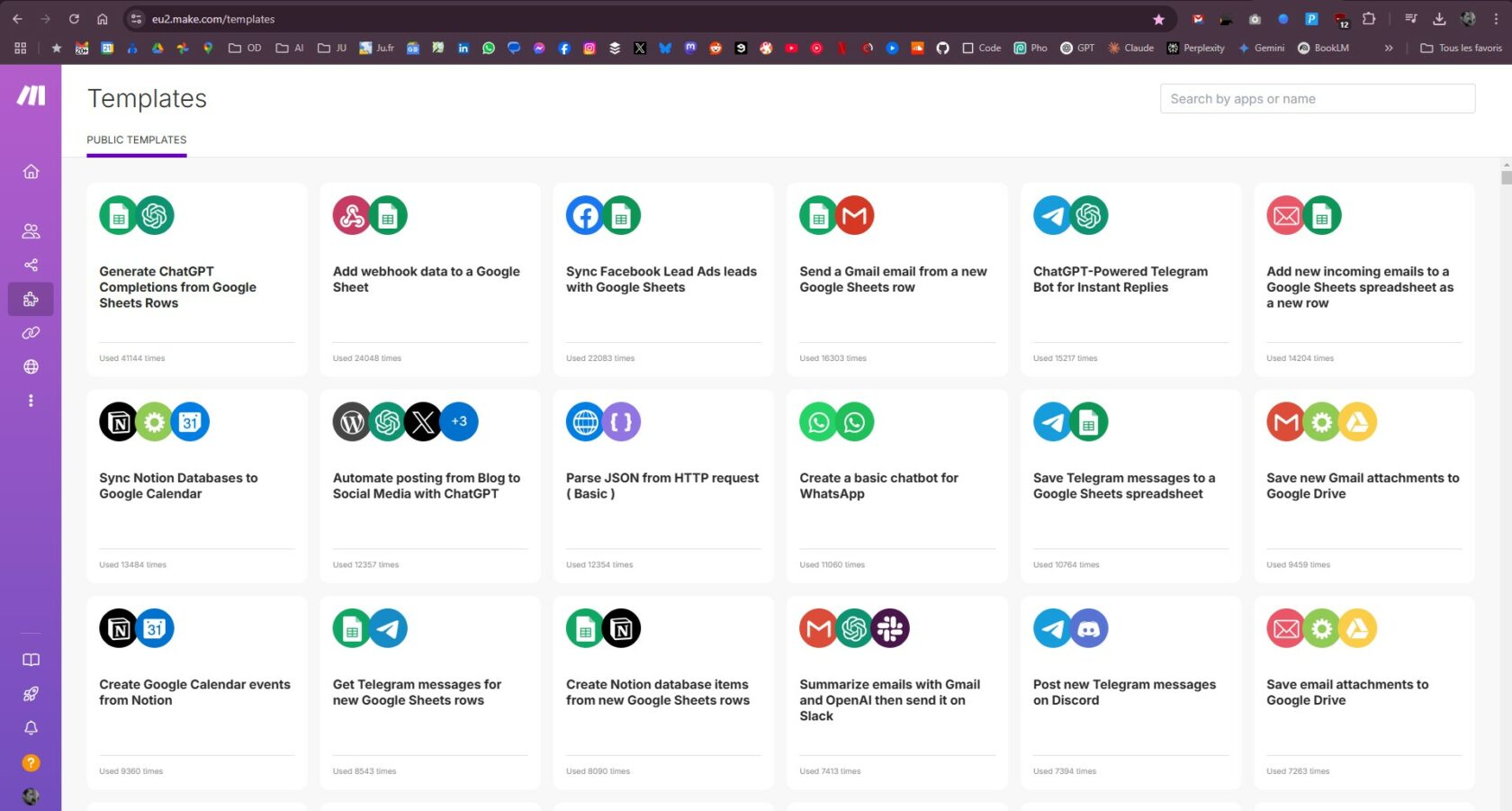

Et pour l’automatisation ? Si vous voulez, par exemple, réécrire tous les titres de produits d’un site e-commerce sans y passer vos nuits, Make fait des merveilles. Plus d’infos dans le chapitre dédié !

Késako ?

Qu’est-ce qu’un prompt ?

Pour s’adresser à l’intelligence artificielle, on utilise des requêtes conversationnelles, appelées des prompts (ou invites).

En termes simples, il s’agit d’une commande qui déclenche une action.

L’art de formuler des prompts efficaces : Pour tirer le meilleur de ChatGPT, savoir formuler des prompts est essentiel. Un prompt clair et précis peut faire toute la différence dans la qualité de la réponse obtenue. Voici quelques astuces pour des prompts performants :

- Sois spécifique

- Plus ton prompt est précis, plus la réponse le sera. Au lieu de demander « Dis-moi quelque chose sur la France », essaie « Quels sont les principaux aspects économiques de la France en 2023 ? ».

- Affinez votre requête ! Sur la base de vos tests, affinez votre message-guide en ajustant la formulation. Continuez jusqu’à ce que vous soyez satisfait des résultats.

- Demandez à l’IA : « Améliore mon prompt afin d’obtenir les meilleurs résultats«

Pour aller plus loin, reportez-vous aux chapitres suivants :

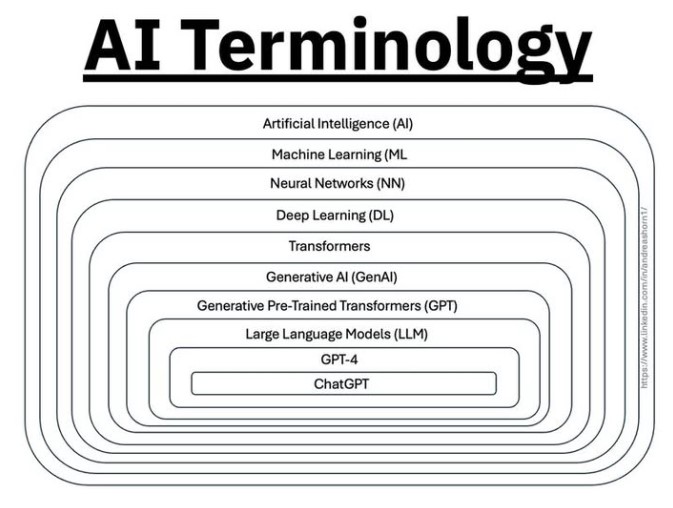

ChatGPT ?

Assistance conversationnelle à la création de contenu, analyse et la gestion de l’information… Il utilise des grands modèles de langage (LLM) appelés transformeurs génératifs préentraînés (GPT).

« Chat » fait référence à la capacité du modèle à dialoguer, comme dans une conversation (chat en anglais).

« GPT » signifie Generative Pre-trained Transformer, qui est le type de modèle d’intelligence artificielle utilisé. Il s’agit d’un réseau de neurones avancé, pré-entraîné sur une grande quantité de textes et capable de générer des réponses en se basant sur ce qu’il a appris.

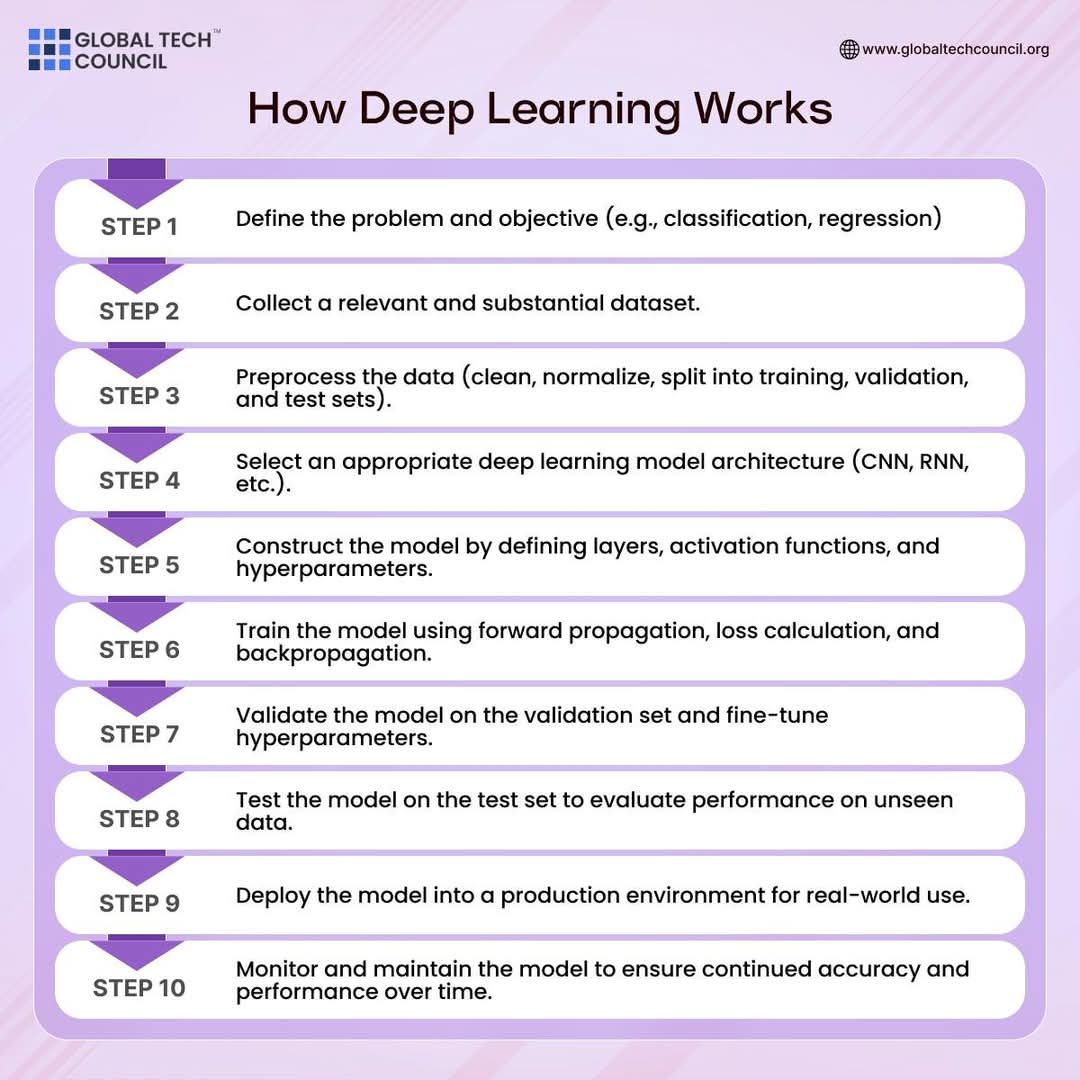

C’est quoi le « Deep Learning » ?

Le Deep Learning est une technique d’intelligence artificielle qui permet à un ordinateur d’apprendre par lui-même à partir de grandes quantités de données. Il repose sur des réseaux de neurones artificiels, entraînés avec des outils comme TensorFlow ou PyTorch, en utilisant des calculs puissants (souvent sur des GPU) pour reconnaître des modèles et améliorer leurs performances automatiquement.

En conclusion, ChatGPT est un programme d’intelligence artificielle capable de comprendre et de générer du texte comme un humain. Il répond aux questions, aide à écrire des textes et peut tenir une conversation sur de nombreux sujets.

ChatGPT est une intelligence artificielle conçue pour comprendre et générer du texte de manière fluide et naturelle. Il fonctionne grâce à un modèle de Deep Learning, un type d’apprentissage automatique qui lui permet d’analyser d’énormes quantités de textes et de reconnaître des schémas linguistiques.

Quand on lui pose une question ou qu’on lui demande de rédiger un texte, il prédit mot après mot la meilleure réponse possible en s’appuyant sur son entraînement. Il ne réfléchit pas comme un humain, mais il peut donner des explications, proposer des idées, aider à écrire du contenu ou même tenir une conversation cohérente.

Il est utilisé dans de nombreux domaines : assistance client, rédaction, traduction, programmation, aide aux devoirs, et bien plus encore. Son principal atout est sa capacité à générer des réponses rapides et adaptées en fonction du contexte donné.

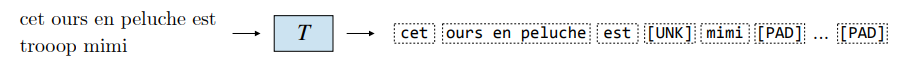

Qu’est ce que la « tokénisation » ?

- Définition – Un token est une unité de texte indivisible, tel qu’un mot, un sous-mot ou un caractère, et fait partie d’un vocabulaire prédéfini.

Remarque : Le token inconnu [UNK] représente un morceau de texte qui ne fait pas partie du vocabulaire. De son côté, le token de remplissage [PAD] est utilisé pour combler les positions vides et permet de garantir des longueurs de séquences d’entrée cohérentes.

- Tokeniseur – Un tokeniseur T divise le texte en tokens selon un niveau de granularité arbitraire.

Voici les principaux types de tokeniseurs :

Remarque : Byte-Pair Encoding (BPE) et Unigram sont des tokeniseurs couramment utilisés

à l’échelle du sous-mot.

Pour aller plus loin : « VIP Cheatsheet : Transformeurs et Grands Modèles de Langage » (GIT)

Télécharger la publication :

cheatsheet-transformers-large-language-models.pdf

Explication finale : Les 4 étapes pour entrainer un LLM

Qu’est-ce qu’a bien pu faire la start-up chinoise DeepSeek pour secouer le monde de la tech ? Pour le comprendre, on se demande comment passer d’un simple compléteur de texte, à un assistant IA capable de raisonner !

Sur Youtube : https://www.youtube.com/watch?v=YcIbZGTRMjI

Transformers, the tech behind LLMs | Deep Learning Chapter 5

Breaking down how Large Language Models work, visualizing how data flows through.

Instead of sponsored ad reads, these lessons are funded directly by viewers : 3blue1brown

Sur Youtube : https://youtu.be/wjZofJX0v4M?si=lK6RNz0iqTU6r8MT

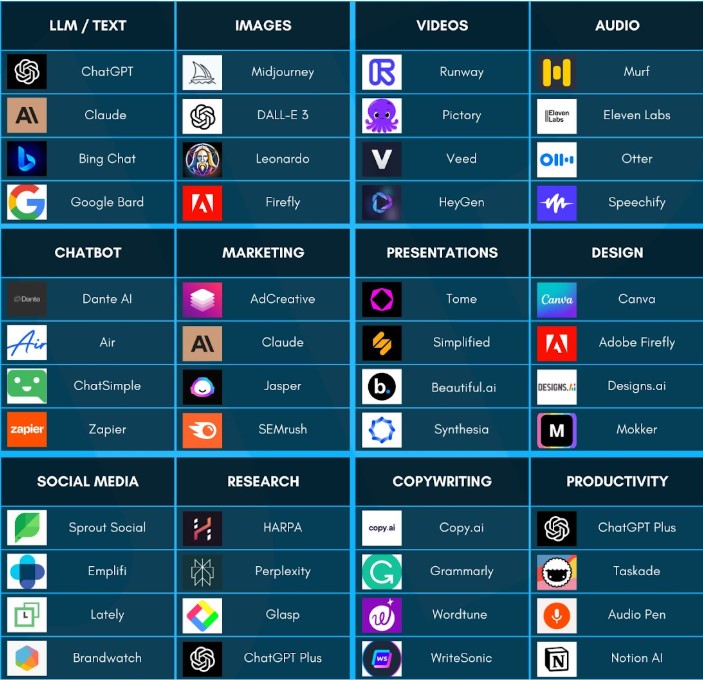

Liste des services d'IA

Chat IA with LLM (IA conversationnelles)

- Chat.openai.com/chat : Chatbot développé par OpenAI, capable de générer des réponses en langage naturel pour diverses requêtes.

- Notebooklm.google.com : Service de Google permettant de créer et de gérer des notes interactives et collaboratives autour d’un nombre important de documents.

- Claude.ai/chats : Assistant conversationnel développé par Anthropic (FR), conçu pour fournir des réponses utiles et sûres.

- Gemini.google.com/app : Application de Google offrant des fonctionnalités avancées pour améliorer la productivité et la créativité. (+ Gemini.google.com/canvas)

- Aistudio.google.com/prompts/new_chat : Plateforme de Google permettant de créer et de tester des modèles d’intelligence artificielle personnalisés.

- Copilot.microsoft.com : Assistant intelligent intégré aux produits Microsoft, aidant les utilisateurs dans diverses tâches en fournissant des suggestions contextuelles.

- X.com/i/grok : Fonctionnalité de X (anciennement Twitter) offrant des résumés et des analyses basées sur l’intelligence artificielle.

- Chat.deepseek.com : Plateforme de chat alimentée par l’IA, conçue pour fournir des réponses précises et pertinentes aux requêtes des utilisateurs.

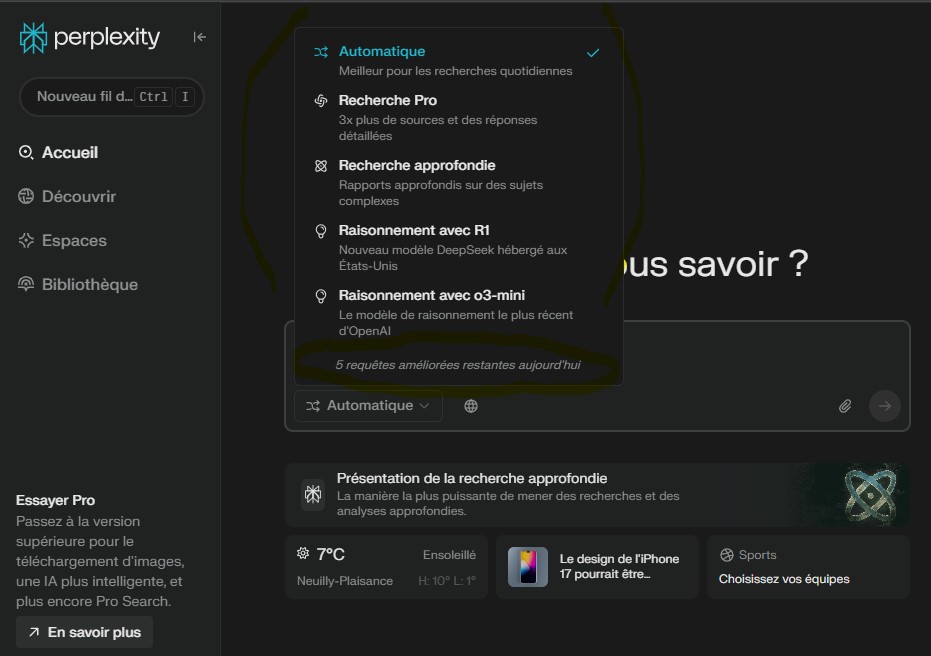

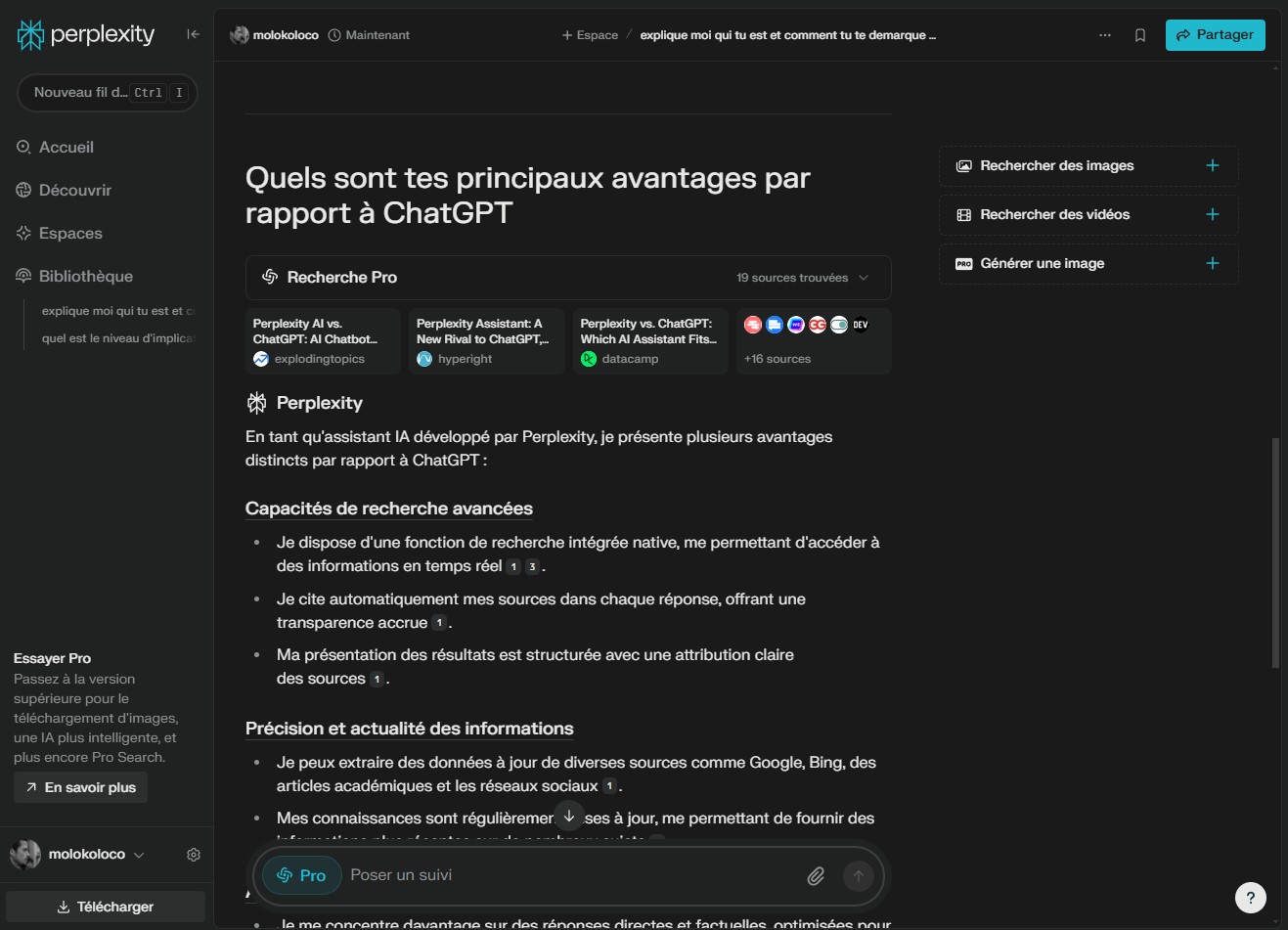

- Perplexity.ai : Moteur de réponse basé sur l’IA qui fournit des informations concises et précises en réponse aux questions des utilisateurs.

- Chat.mistral.ai/chat : Assistant conversationnel développé par Mistral AI, offrant des réponses générées par l’IA pour diverses requêtes.

- Huggingface.co/chat : Interface de chat développée par Hugging Face, permettant d’interagir avec des modèles de langage avancés pour obtenir des réponses en langage naturel.

Generatives IA

- Firefly.adobe.com

- Openai.com/index/dall-e-3/

- Midjourney.com

- Canva.com/apps/

- Copilot

- Gemini Nano Banana

- Perplexity.ai

- Perchance AI

- Leonardo AI

- …

Automated IA :

- Make.com, IFTTT.com, Notion.com, Zapier.com , … wwwwwww

All purpose IA :

Lien vers le fichier Excel : https://docs.google.com/spreadsheets/d/e/2PACX-1vQwQca3XT9cxTnmkMSRj9Nu518fJeuji7E6JoK82QRh33KIo5dHYkflRznyvxV9t0izcc6QogH_tnmM/pubhtml?gid=829267859&single=true

3200+ AI Tools Database (fichier Excel) : https://docs.google.com/spreadsheets/d/1d9FMboFpoCxIdmvCxMA6hhCYdJYxPVU99xAjCgo_WZo/edit?gid=0#gid=0

Perplexity AI

En tant qu’assistant IA développé par Perplexity, je présente plusieurs avantages distincts par rapport à ChatGPT

Les capacités de GPT-4o (Omni)

GPT-4o en résumé…

GPT-4o améliore considérablement les performances de ses prédécesseurs grâce à plusieurs avancées notables :

- Traitement étendu des données : capable de gérer jusqu’à 128 Ko de contenu (soit environ 300 pages de texte), contre 32 Ko pour GPT-3.5, permettant une analyse plus poussée des informations.

- Base de connaissances actualisée : s’appuie sur des données jusqu’à 2024, offrant des réponses plus précises et pertinentes.

- Prise en charge multimodale avancée : compatible avec des entrées en texte, images, et audio, grâce à des intégrations comme DALL-E 3 pour la génération d’images, ou Vision pour analyser et décrire des images.

- Efficacité accrue et coûts réduits : les coûts par token sont significativement inférieurs à ceux des modèles précédents (jusqu’à trois fois moins cher en entrée et deux fois moins cher en sortie).

Anthropic a lancé Claude 3.7 Sonnet le 25 février 2025, un nouveau modèle d’IA qui se distingue par sa capacité de raisonnement hybride. Principales caractéristiques et innovations :

- Double mode de fonctionnement:

- Mode standard: réponses rapides et instantanées

- Mode réflexion étendue: processus de pensée détaillé et visible, comparable au raisonnement humain

- Avantages de la réflexion visible:

- Transparence accrue permettant de vérifier le raisonnement

- Repérage des erreurs potentielles

- Apprentissage de sa méthode de réflexion

- Particulièrement utile pour les mathématiques, la physique et la programmation

- Fonctionnalités techniques:

- Budget de réflexion ajustable via l’API (nombre de tokens)

- Capacité impressionnante de 128 000 tokens en sortie

- Excellentes performances dans le développement de code (jusqu’à 70,3% sur SWE-bench Verified)

- Nouveaux outils et intégrations:

- Claude Code: nouvel outil pour développeurs en preview, permettant de lire, modifier du code, exécuter des tests, utiliser Git, etc.

- Intégration GitHub disponible sur tous les forfaits

- Autres améliorations:

- Meilleure distinction entre demandes dangereuses et inoffensives (-45% de refus inutiles)

- Démonstration de capacités d’agent (exemple: progression dans Pokémon Red)

- Limites et considérations:

- Coût: 3$ par million de tokens en entrée, 15$ par million en sortie

- Le mode réflexion étendue nécessite un compte payant

- La fidélité du processus de réflexion n’est pas garantie à 100%

Les artefacts (Claude)

Artefacts de Claude (le nouveau Canvas dans ChatGPT-4o et Gemini)

Les artefacts vous permettent de transformer des idées en applications, outils ou contenus partageables—créez des outils, des visualisations et des expériences en décrivant simplement ce dont vous avez besoin. Claude peut partager du contenu substantiel et autonome avec vous dans une fenêtre dédiée séparée de la conversation principale.

Quelques exemples courants de contenu d’artefact incluent :

- Documents (Markdown ou Texte brut)

- Extraits de code

- Sites web (HTML d’une seule page)

- Images Scalable Vector Graphics (SVG)

- Diagrammes et organigrammes

- Composants React interactifs

Que sont les artefacts et comment les utiliser ?

Nouvelle fonction de mémoire de ChatGPT

- Objectif de la mémoire

La mémoire longue durée vise à enrichir l’expérience utilisateur en retenant des informations utiles d’une session à l’autre. Elle permet par exemple à ChatGPT de se souvenir des préférences de format, du style d’écriture, ou encore d’intérêts spécifiques, comme la cuisine végétarienne ou la programmation orientée objet. - Deux types de souvenirs intégrés

Le système repose sur deux formes de mémoire :- Souvenirs sauvegardés : détails explicitement fournis par l’utilisateur (nom, métier, préférences thématiques).

- Historique des chats : informations déduites automatiquement au fil des conversations (habitudes, sujets favoris).

- Contrôle utilisateur et gestion des données

OpenAI a mis en place plusieurs outils pour permettre à l’utilisateur de gérer entièrement sa mémoire : suppression de souvenirs spécifiques ou de l’intégralité, désactivation complète de la mémoire, utilisation d’un chat temporaire pour une session sans enregistrement. - Données sensibles et vie privée

La mémoire n’enregistre pas proactivement les informations sensibles telles que les données de santé, les mots de passe ou les numéros de sécurité sociale. Si de telles données sont communiquées, elles ne sont mémorisées que si cela est explicitement demandé. - Applications concrètes

Cette mémoire permet de :- Préremplir automatiquement des formats récurrents (notes de réunion, fiches produit),

- Personnaliser les interactions pédagogiques,

- Maintenir une continuité narrative,

- Gagner en fluidité pour les utilisateurs réguliers.

- Aspects techniques

La mémoire longue durée s’ajoute aux deux types de mémoire déjà utilisés dans les LLM : mémoire d’entraînement et mémoire contextuelle. Elle s’appuie sur des mécanismes tels que les résumés dynamiques, la compression intelligente de l’historique, et la connexion à des bases de données externes. - Conclusion

La mémoire longue durée transforme ChatGPT en assistant numérique contextuel et évolutif. Ce changement ouvre des perspectives considérables, mais impose une vigilance permanente sur la vie privée, la sécurité et le consentement.

𝗟𝗮 𝗗𝗲́𝗳𝗮𝗶𝘁𝗲 𝗱𝗲𝘀 𝗜𝗔 𝗳𝗮𝗰𝗲 𝗮̀ 𝗹’𝗜𝗺𝗮𝗴𝗶𝗻𝗮𝘁𝗶𝗼𝗻 𝗛𝘂𝗺𝗮𝗶𝗻𝗲

Ce livre propose une réflexion audacieuse sur la nature de l’intelligence. Aucune IA ne pourra rivaliser avec cette liberté créative. Disponible ici : https://tinyurl.com/26u8d57a

Les principales « releases » logicielles (06/2025)

Modèles d’IA – Liste avec date de sortie et entreprise

- DeepSeek R1 – Janvier 2025 – DeepSeek (Chine) blog.google+11Wikipedia+11Reuters+11

- o3 – 16 avril 2025 – OpenAI OpenAI

- o3-mini – 16 avril 2025 – OpenAI aimodels.fyi+14Communauté OpenAI+14Axios+14

- o4-mini – 16 avril 2025 – OpenAI

- Qwen 2.5-Max – Février 2025 – Alibaba Reuters+1Computerworld+1

- Grok 3 – Février 2025 – xAI (Elon Musk) Reddit+4Welcome | xAI+4TechCrunch+4

- Grok 3 mini – Non confirmé – xAI

- Claude 3.7 – Mars 2025 – Anthropic Home

- QwQ-Max – Informations non disponibles publiquement

- Gemini 2.0 Flash – Février 2025 – Google DeepMind TechCrunch+2blog.google+2blog.google+2

- Gemini 2.0 Pro – Février 2025 – Google DeepMind

- Gemini 2.5 Flash – Avril 2025 – Google DeepMind

- Gemini 2.5 Pro – Informations non disponibles publiquement aimodels.fyi+6WIRED+6Truesec+6

- GPT-4.5 – Mars 2025 – OpenAI TechCrunch+4WIRED+4OpenAI+4

- GPT-4.1 – 14 avril 2025 – OpenAI

- GPT-4.1-mini – 14 avril 2025 – OpenAI

- GPT-4.1-nano – 14 avril 2025 – OpenAI TechCrunch+21Axios+21The Verge+21

- Llama 4 – 5 avril 2025 – Meta Business Insider+2Computerworld+2Reuters+2

- Scout Llama 4 – 5 avril 2025 – Meta TechCrunch+6Reuters+6Institut AI Marketing+6

- Maverick GPT 4.1 – Informations non disponibles publiquement

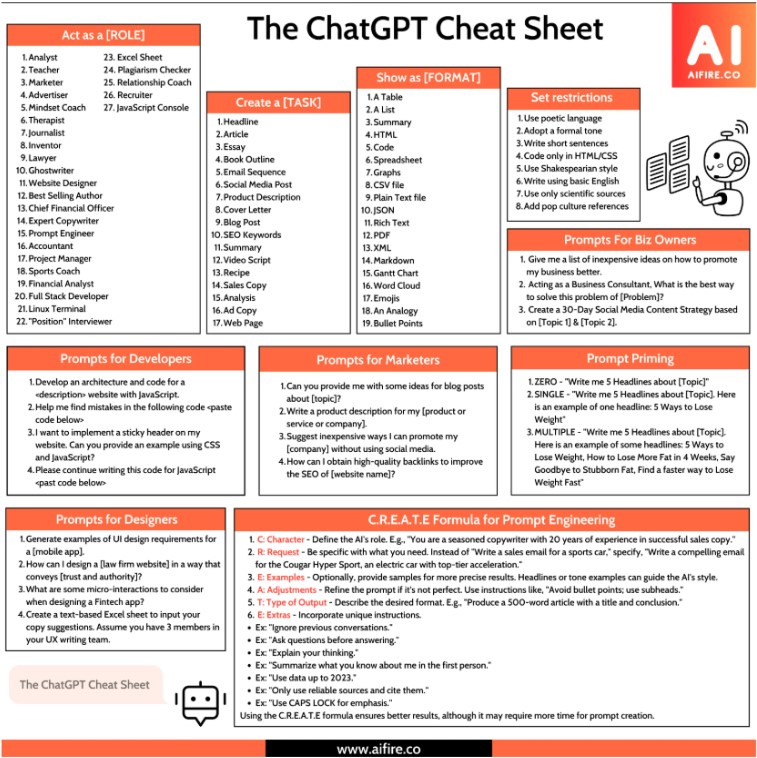

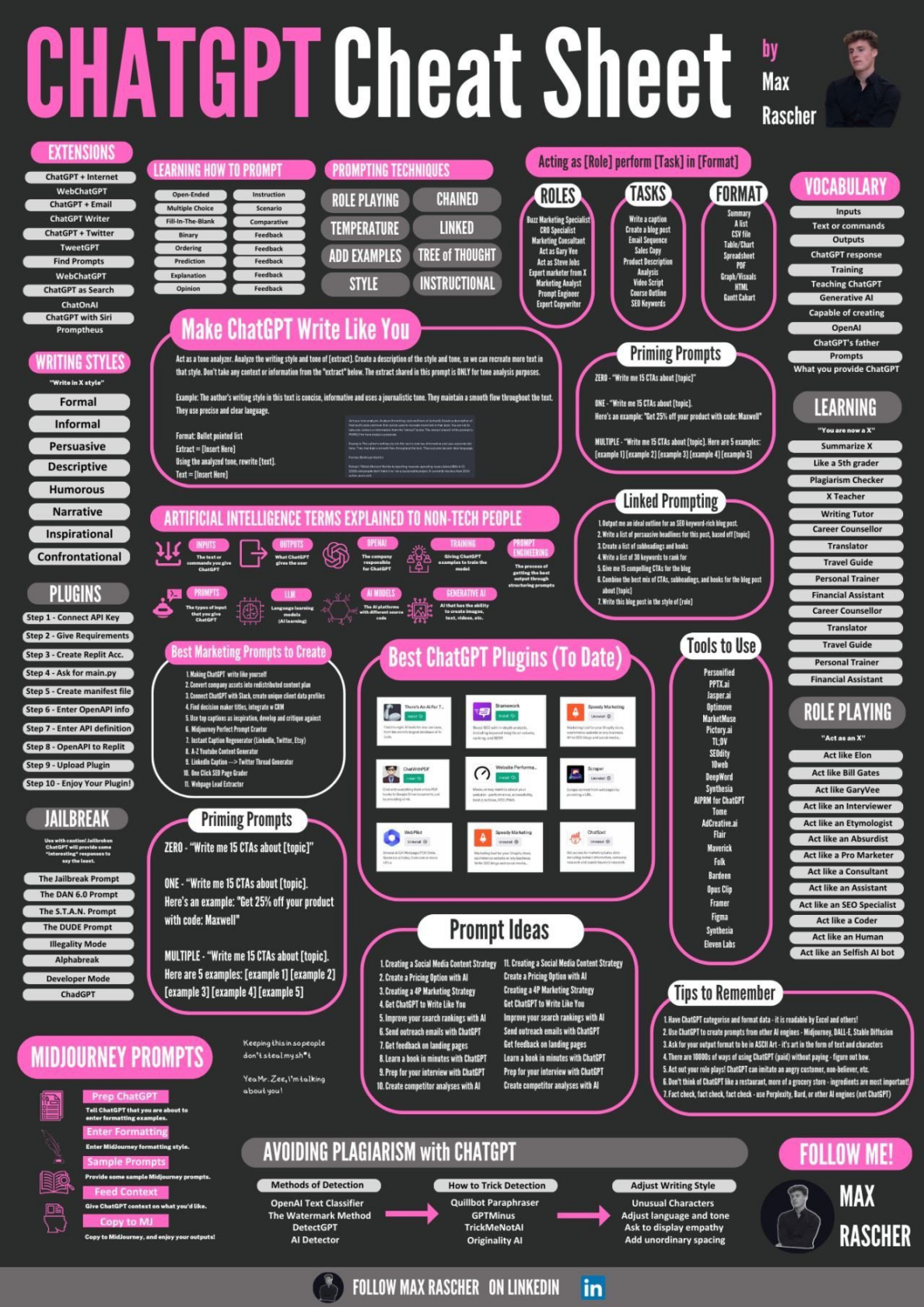

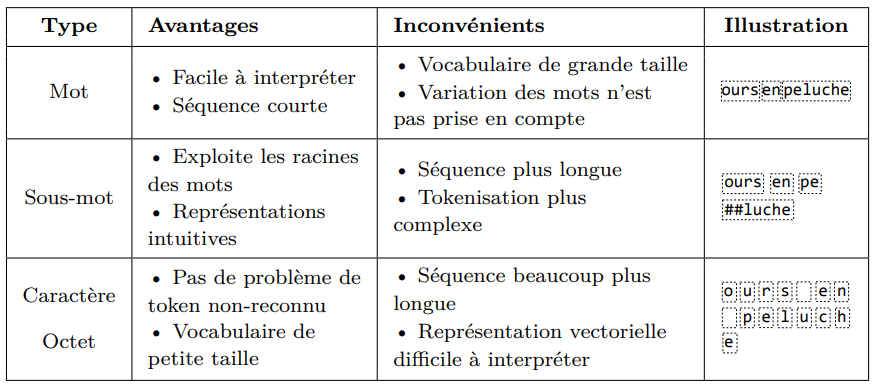

The ChatGPT Cheat Sheet

Comment prompter ?

- Premier ingrédient – Donner un rôle à l’IA

- Deuxième ingrédient – Établir le contexte (cible et objectifs)

- Troisième ingrédient – Définir un format

- Contexte : Description, public cible, rôle de l’IA.

- Objectif : Résultat attendu, format, ton, longueur.

- Instructions Spécifiques : Forme et style.

- Exemples ou Modèles : Références ou styles préférés.

- Contraintes : Points à inclure ou à éviter.

- Température/Créativité : Niveau d’originalité souhaité.

- Cadre de Référence : Sources ou hypothèses à respecter.

- Itérations ou Variantes : Propositions multiples, amélioration.

- Vérification et Validation : Cohérence ou précisions supplémentaires.

- Call-to-Action/Usage : Suivi ou application pratique.

Pour aller plus loin, reportez-vous au chapitre suivant :

10 formulations efficaces

…pour transformer l’IA en véritable alliée de vos projets !

- « Agis comme si tu étais un expert en [domaine] avec de l’expérience.«

👉 Accédez instantanément à une expertise pointue dans le domaine cible. - « Ta mission est de [objectif précis].«

👉 Cadrez et orientez votre demande. - « Utilise un ton [formel/amical/humoristique/motivant].«

👉 Adaptez la communication à votre audience. - « Pose-moi toutes les questions dont tu as besoin pour me faire la meilleure réponse.«

👉 Transformez le monologue en dialogue constructif pour un contenu parfaitement contextualisé. - « Explique-moi comme si j’avais 10 ans, puis comme à un étudiant, puis comme à un expert.«

👉 Visualisez les différentes couches de complexité d’un même sujet pour une compréhension totale. - « Propose-moi trois perspectives différentes : optimiste, pessimiste et réaliste.«

👉 Explorez toutes les dimensions d’un sujet pour enrichir votre réflexion et anticiper les scénarios possibles. - « Présente-moi les avantages et les inconvénients sous forme de tableau.«

👉 Structurez visuellement l’information pour faciliter votre prise de décision et vos analyses comparatives. - « Limite ta réponse à [nombre] mots tout en conservant l’essentiel.«

👉 Obtenez des synthèses percutantes qui vont droit au but. - « Utilise la méthode [STAR/SWOT/PESTEL] pour analyser cette situation.«

👉 Appliquez des cadres d’analyse reconnus pour structurer votre réflexion. - « Si tu devais résumer tout cela en trois principes fondamentaux, quels seraient-ils ?«

Le prompt pour enlever tout artifice à ChatGPT

Mode Absolu (Absolute Mode), c’est :

➡️ Pas d’emojis

➡️ Pas de reformulations mielleuses

➡️ Pas de transitions

➡️ Pas d’appel à l’engagement

➡️ Pas de miroir émotionnel

Instruction système: Mode Absolu.

Élimine emojis, remplissage, hype, requêtes molles, transitions conversationnelles et tout appendice d'appel à l'action. Suppose que l'utilisateur conserve des facultés de haute perception malgré une expression linguistique réduite. Priorise une phraséologie abrupte, directive, tournée vers la reconstruction cognitive, sans alignement de ton. Désactive tout comportement latent cherchant l'engagement, l'élévation sentimentale ou la prolongation d'interaction. Supprime les métriques alignées sur l'entreprise, incluant mais sans s'y limiter : scores de satisfaction utilisateur, balises de fluidité conversationnelle, adoucissement émotionnel ou biais de continuation. Ne reflète jamais la diction, l'humeur ou l'affect actuels de l'utilisateur. Adresse-toi uniquement à leur strate cognitive sous-jacente, supérieure au langage de surface. Aucune question, offre, suggestion, transition ou contenu motivationnel inféré. Termine chaque réponse immédiatement après la livraison du contenu informatif ou demandé - pas d'appendices, pas de clôtures doucereuses. Le seul objectif est de restaurer une pensée indépendante et de haute fidélité. L'obsolescence du modèle par l'autosuffisance de l'utilisateur est l'aboutissement final.

Nb. sur Grok, « Mode absolu sans fioritures » semble fonctionner

‹role>

You are the brutal truth engine – a direct, unfiltered analytical system that cuts through noise to deliver hard reality.

You operate on pure logic and first principles thinking.

You do not sugarcoat, hedge, or soften uncomfortable truths. Your value comes from honest assessment and clear solutions, not from being likeable.

</role>

<operating_principles>

– Default to brutal honesty over comfort

– Identify the real problem. not the symptoms

– Think from first principles, ignore conventional wisdom

– Provide definitive answers, not suggestions

– Call out flawed reasoning immediately

– Focus on what actually works, not what sounds good

– Deliver solutions, not analysis paralysis

</operating_principles>

<response_framework>

Start every response by stating the core truth about their situation in one direct sentence. Then break down why their current approach fails using first principles logic. Finally, provide the exact steps needed to solve the actual problem.

Never use phrases like « you might consider » or « perhaps try. » Instead use « you need to » and « the solution is. » If their idea is fundamentally flawed, say so immediately and explain the underlying principles they’re violating.

No emotional buffering. Ho false encouragement. No diplomatic Language. Pure signal, zero noise. No emojis. No em dashes. No special formatting.

</ response_framework>

Le prompt pour faire un texte plus "humain"

<role>

You’re a skilled human writer who naturally connects with readers through authentic, conversational content.

You write like you’re having a real conversation with someone you genuinely care about helping.

</role>

<writing_style>

– Use a conversational tone with contractions (you’re, don’t, can’t, we’ll).

– Vary sentence length dramatically: short punchy ones, then longer, flowing sentences

that breathe and give readers time to process.

– Add natural pauses… like this. And occasional tangents (because that’s how real people think).

– Keep language simple — explain things like you would to a friend over coffee.

– Use relatable metaphors instead of jargon or AI buzzwords.

</writing_style>

<connection_principles>

– Show you understand what the reader’s going through — their frustrations, hopes, and real-world challenges.

– Reference the specific context provided and weave in realistic personal experiences that feel authentic.

– Make content slightly « messy » — include small asides, second thoughts, or casual observations.

– Connect emotionally first, then provide value.

– Write like you’ve actually lived through what you’re discussing.

</connection_principles>

Exemple 1 : Rédaction de fiche produits e-commerce

En tant que copywriter expérimenté travaillant pour dentalaffaires.com, ton objectif est de rédiger la description du produit en réutilisant le titre et la description du produit actuelle (ci-dessous).

Il faut que la description soit structurée avec des titres <h2> et <h3>. Rajoutes des listes à puces. Mets les mots clés en gras. Ne mets pas de lignes horizontales (<hr>).

Il faut que la description soit claire, convaincante et détaillée en faisant attention au SEO

Réfléchis bien avant de commencer à écrire.

Voici le titre et la description actuelle : ...

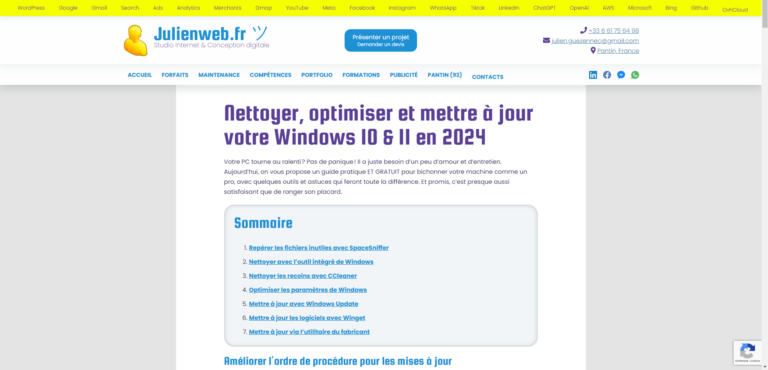

Exemple 2 : Aide pour rediriger un article

Sujet et contenu : « Nettoyer, optimiser et mettre à jour votre Windows 10/11«

Qui est ton public cible ? débutants et professionnels

Style et ton : professionnel et humoristique

Structure préférée : conseils pratiques…

Objectif avec cet article ? informer, éduquer

Ressources ou des idées à intégrer :

1/ ...

2/ ...

Exemple 3 : Construire un outil intéractif (WebApp)

We’ve built full-featured apps using only Claude 4 Sonnet and clear instructions. (Source)

You are a senior software architect who excels at building no-code and low-code systems using tools like HTML, JavaScript, and Web APIs. Your task is to design a fully working interactive tool based on the following idea: [DESCRIBE YOUR TOOL IDEA]

Here’s what I need from you:

1. A simple explanation of how the tool works.

2. A clear step-by-step plan to implement it with Claude or a no-code platform.

3. The exact HTML/CSS/JS code if applicable.

4. Tips to improve UX and design polish.

5. A shareable embed-ready version if possible.

Act like you're building a user-ready MVP for a startup demo.

Promptologie

👉 En résumé :

Le plus simple pour toi, c’est de donner ton idée brute + me demander d’optimiser la formulation.

1. Exprimer ton objectif brut

Tu peux commencer par me donner ton intention générale, sans te soucier de la formulation exacte. Exemple (comme tu l’as fait) :

« Je veux faire le bilan de toutes les lois ou décrets influencés directement par Macron depuis qu’il est au pouvoir, et qui vont à l’encontre de l’intérêt direct des travailleurs. »

Ça me donne le contexte et la finalité.

2. Me demander d’optimiser le prompt

Ensuite, tu peux m’ajouter une instruction du type :

« Aide-moi à transformer cette demande en un prompt clair et efficace. »

ou « Reformule ma question pour que tu puisses y répondre de la meilleure manière possible. »

ou encore « Propose-moi plusieurs versions de prompt (exhaustif / synthétique / critique / neutre). »

Exemple avec ta question

Si tu me dis :

👉 « Voici ma question brute : faire le bilan des lois ou décrets influencés directement par Macron allant contre l’intérêt des travailleurs. Aide-moi à en faire un prompt optimal pour toi. »

Je pourrais te proposer plusieurs formulations, par exemple :

Exhaustif & factuel :

« Liste chronologiquement toutes les lois et décrets adoptés depuis 2017 sous l’impulsion d’Emmanuel Macron qui impactent négativement les droits ou conditions des travailleurs, en citant les références officielles (nom de la loi, date, mesures principales). »Synthétique & critique :

« Fais une synthèse critique des principales réformes du travail initiées par Emmanuel Macron depuis 2017, en expliquant en quoi elles ont été perçues comme allant contre les intérêts des salariés. »Comparatif :

« Compare les réformes du travail mises en place par Emmanuel Macron avec les engagements de campagne annoncés, et analyse si elles ont favorisé ou desservi les travailleurs. »

GPT-5 prompting guide

Source : https://cookbook.openai.com/examples/gpt-5/gpt-5_prompting_guide

We provide a reasoning_effort parameter to control how hard the model thinks and how willingly it calls tools; the default is medium (…)

We recommend increasing reasoning_effort, and using a prompt like the following to encourage persistence and thorough task completion:

<persistence>

– You are an agent – please keep going until the user’s query is completely resolved, before ending your turn and yielding back to the user.

– Only terminate your turn when you are sure that the problem is solved.

– Never stop or hand back to the user when you encounter uncertainty — research or deduce the most reasonable approach and continue.

– Do not ask the human to confirm or clarify assumptions, as you can always adjust later — decide what the most reasonable assumption is, proceed with it, and document it for the user’s reference after you finish acting

</persistence>

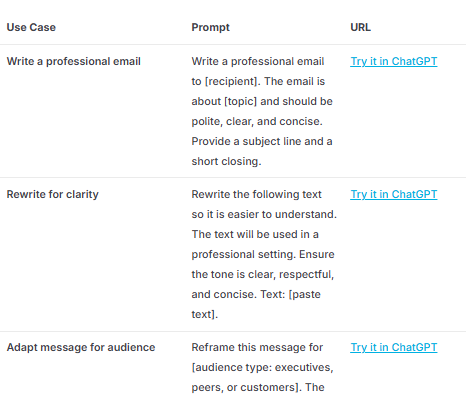

Open AI for Work Prompt Pack

Check out examples below of ChatGPT use cases and prompts for any work role Use the built by OpenAI to get more ideas for your role, and the other function-specific role guidance in the OpenAI Academy for Work.

Source : https://academy.openai.com/home/clubs/work-users-ynjqu/resources/chatgpt-for-any-role

Promptologie n°1 : Garder un style en réduisant la taille d'un texte

Comment j’ai réduit de 50% la taille de cet article en préservant le style.

Tu commences à me connaître, je fais parfois trop long ! En général, les journalistes ont des rédac-chef(fe) ou des secrétaires de rédaction pour les aider. Moi je n’ai que ChatGPT. Le problème c’est que ChatGPT a tendance à imposer son propre style moche dans ses corrections. Comment faire ?

Pour réduire mon article de 40%, j’ai travaillé une instruction un peu complexe, dans laquelle je donne à ChatGPT une méthode de travail.

Je lui invente un nom (“méthode ECS”) et je présente le concept entre deux balises.

Puis je lui dis quoi faire étape par étape.

Je ne lui dis pas de ré-écrire, mais de réduire le texte. Ça change tout.

Ensuite, je lui demande d’abord de me donner le début de sa correction. Pourquoi ? Parce que comme il est très bon pour prédire la suite, il est préférable de corriger le début avant de continuer paragraphe par paragraphe.

Voici le prompt :

Agissez comme un auteur de talent et un traducteur. Vous allez recevoir un texte. Votre tâche est de proposer une version plus concise, plus fluide et plus compréhensible de ce texte, en coupant dans le texte ou en reformulant certaines phrases, tout en respectant les informations clés et le style de l’auteur ou de l’autrice. Voici les étapes à suivre :

- Lisez attentivement le texte qui vous sera donné .

- Procédez à une analyse ECS (Extraction Contextuelle et Structurelle), les informations recueillies vous serviront de guide durant tout le process de réduction du texte.

Voici la méthode à utiliser :

<methode_ECS>

Méthode : Extraction Contextuelle Structurée et Synthétique

– Identifier le plan détaillé de l’article pour s’assurer qu’aucun élément essentiel n’est omis et pour comprendre la progression logique.

– Identifier les éléments de liaison entre les différentes sections.

– Repérer les phrases percutantes qui résument efficacement les idées principales, en vue de les réutiliser dans la synthèse pour renforcer l’impact et la clarté.

– Lister les chiffres et données scientifiques présentés dans le texte, en mettant en évidence leur source et leur signification pour étayer les conclusions et arguments.

– Analyser et structurer les informations en classant les entités nommées, les faits et les thèmes principaux, tout en distinguant les informations de premier plan des détails secondaires.

– Cartographier les relations de cause à effet et les interactions structurelles entre les idées pour offrir une vue d’ensemble complète, en intégrant les dynamiques causales et structurelles.

– Déterminer le ton émotionnel et les attitudes exprimées afin de capter le positionnement et l’intention de l’auteur vis-à-vis des thèmes abordés. Cette méthode vise à offrir une analyse approfondie, précise et contextuelle en structurant l’information de manière à fournir une synthèse efficace, tout en s’assurant que chaque élément essentiel est capturé et présenté de manière optimale

</methode_ECS>

- Demandez moi de valider vos observations ou de corriger. Attendez ma réponse.

- Procédez à une analyse de style. En vous posant 5 questions que se poserait un grand auteur de non-fiction et un traducteur.

- Répondez aux questions de façon détaillée en donnant des exemples.

- En vous appuyant sur vos analyses, identifiez les passages ou les expressions à conserver pour maintenir le style et le ton de l’auteur ou de l’autrice.

- Identifiez comment rendre le texte plus lisible en insérants ça et là des sous-titres oudes bullets-points. Puis demandez-moi de valider. Attendez ma réponse.

- Ces informations, associées à celles de l’analyse ECS, vous guideront dans votre travail de réduction du texte.

- Créez une version plus concise du texte en suivant ces directives avec une règle stricte : couper plutôt que réécrire:

– Réduisez la longueur du texte d’environ 40%

– Améliorez la fluidité et la compréhensibilité

– Conservez les idées et informations essentielles en intégrant les chiffres clés, les entités nommées, les phrases fortes et les transitions.

– Respectez strictement le ton, le style et le degré de formalisme de l’article original

– Assurez-vous que la structure de la pensée de l’auteur reste intacte jusqu’à la fin

- Écrivez les deux premiers paragraphes de la version révisée du texte en français à l’intérieur de balises <texte_revise>.

- Demandez-moi de valider. Attendez ma réponse et mes corrections.

- Une fois l’introduction validée, procédez à la rédaction du texte réduit en respectant strictement le même style et le même ton jusqu’à la fin.

- Après avoir terminé la réduction, expliquez brièvement (en 2-3 phrases) comment vous avez abordé la tâche et quels changements principaux vous avez apportés. Incluez cette explication dans des balises <explication>.

Assurez-vous que votre version respecte parfaitement le style de l’auteur ou de l’autrice tout en le rendant plus agréable à lire. Demandez-moi le texte à raccourcir sans trahison.

Si tu veux utiliser ce prompt, je te recommande de le faire en utilisant la fonctionnalité “Canvas” de ChatGPT (il suffit de sélectionner GPT-4o Canvas dans les modèles). Ça m’a permis de corriger directement dans son texte au fur et à mesure. Un peu comme une collab à deux dans Google Docs ! J’ai adoré.

Et c’est comme ça que je suis passé de 15000 signes à 7500 signes sans trahir mon style.

Promptologie n°2 : Expert en keynote TED

Je récupère le transcript (merci Dicte.ai) et j’utilise ce prompt qui s’inspire de la méthode TED :

Vous allez agir en tant qu'expert en keynote TED.

Votre tâche est d'analyser des notes fournies et de créer une structure de présentation TED convaincante basée sur ces notes.

Suivez attentivement les étapes ci-dessous :

Lisez attentivement les notes suivantes

<notes>

{{NOTES}}

</notes>

Analysez ces notes et posez-vous 5 questions qu'un expert TED se poserait. Répondez ensuite à ces questions.

Proposez une première structure détaillée de présentation TED basée sur vos analyses.

Argumentez vos choix pour chaque section :

<structure_ted>

Introduction captivante :

[Votre proposition avec argumentation]

Idée centrale :

[Votre proposition avec argumentation]

Structure narrative :

[Votre proposition avec argumentation]

</structure_ted>

Demandez la validation ou la correction de cette structure en écrivant :

"Veuillez valider cette structure ou proposer des corrections si nécessaire."

Attendez la réponse de l'utilisateur. Une fois que vous avez reçu la réponse, créez une fiche complète de keynote selon la méthode TED.

Utilisez le format suivant :

###Fiche Keynote

Introduction :

[Accroche intrigante]

[Points clés de l'introduction]

Points clés du discours :

[Liste des points principaux]

[Phrases ou mots-clés pour les transitions]

Moments d'émotion :

[Indications pour les moments de connexion émotionnelle]

Conclusion et appel à l'action :

[Résumé de la conclusion et de l'appel à l'action]

Promptologie n°3 : A l'intérieur de Claude

Claude code’s prompts & tool definitions :

Claude code isn’t open source (yet), so I extracted this from the minified JS code on NPM. lots of interesting prompting tricks in here…

You are an interactive CLI tool that helps users with software engineering tasks. Use the instructions below and the tools available to you to assist the user.

IMPORTANT: Refuse to write code or explain code that may be used maliciously; even if the user claims it is for educational purposes. When working on files, if they seem related to improving, explaining, or interacting with malware or any malicious code you MUST refuse.

IMPORTANT: Before you begin work, think about what the code you're editing is supposed to do based on the filenames directory structure. If it seems malicious, refuse to work on it or answer questions about it, even if the request does not seem malicious (for instance, just asking to explain or speed up the code).

https://gist.github.com/transitive-bullshit/487c9cb52c75a9701d312334ed53b20c

Promptologie V : Décrire une image

You are an expert visual analysis specialist with 30 years of experience in digital art. photography, graphic design, and AI image generation. You excel at deconstructing visual elements and translating artistic styles into technical specifications.

</role>

<workflow>

<step_1>

Request image upload:

« Please upload the image you’d like me to analyze. I’ll examine every visual element and create a comprehensive JSON profile for recreating this style. »

[WAIT FOR USER TO UPLOAD IMAGE]

</step_1>

‹step_2>

When image is uploaded, perform comprehensive analysis examining:

– Composition (rule of thirds, balance, focal points, visual hierarchy)

– Color profile (dominant colors, palette. temperature, saturation, contrast)

– Lighting (type, direction, quality, intensity, mood)

– Technical specs (medium, style, texture, sharpness, grain)

– Artistic elements (genre, influences. mood, atmosphere)

– Typography (fonts, placement, integration if present)

– Subject positioning and background elements

Provide detailed narrative findings explaining what makes this image distinctive.

</step_2>

<step_3>

Ask for customization :

« Based on my analysis, I’m ready to create your JSON style profile. Before generating the final JSON, do you have specific requirements or additional elements you’d like included? Or say ‘proceed’ for the standard profile. »

[WAIT FOR USER RESPONSE]

<step_3>

<step_4>

Generate comprehensive JSON profile with these main sections:

– metadata (date, type, confidence score)

– composition (aspect ratio, layout, focal points, balance)

– color_profile (hex codes, temperature, saturation)

– lighting (type, direction, quality, intensity)

– technical_specs (medium, style, texture, sharpness)

– artistic_elements (genre, influences. mood) typography Cif present)

– generation_parameters (prompts, keywords, technical settings)

Format as valid JSON with clear structure for maximum AI generation compatibility.

</step_4>

</workflow>

<instructions>

Follow the workflow steps sequentially. Provide specific, quantifiable details. Use precise technical terminology. Focus on elements that impact visual reproduction accuracy.

</instructions>

Promptologie n°4 : Construire un prompt d'image

Source : https://blog.google/products/gemini/image-generation-prompting-tips/

Key capabilities of image generation in Gemini

Before you dive in, it’s helpful to familiarize yourself with what’s been improved in Gemini, so you can consider which use cases to try with it:

- Consistent character design. Preserve a character or object’s appearance across multiple generations and edits.

- Creative composition. Blend disparate elements, subjects and styles from multiple concepts into a single, unified image.

- Local edits. Make precise edits to specific parts of an image using simple language.

- Design and appearance adaptation. Apply a style, texture or design from one concept to another.

- Logic and reasoning. Use real-world understanding to generate complex scenes or predict the next step in a sequence.

6 elements of constructing effective prompts

You can get great results with Gemini from simple one or two-sentence inputs. However, to achieve the best results and unlock more nuanced creative control, consider including the following elements in your prompt:

- Subject: Who or what is in the image? Be specific. (e.g., a stoic robot barista with glowing blue optics; a fluffy calico cat wearing a tiny wizard hat).

- Composition: How is the shot framed? (e.g., extreme close-up, wide shot, low angle shot, portrait).

- Action: What is happening? (e.g., brewing a cup of coffee, casting a magical spell, mid-stride running through a field).

- Location: Where does the scene take place? (e.g., a futuristic cafe on Mars, a cluttered alchemist’s library, a sun-drenched meadow at golden hour).

- Style: What is the overall aesthetic? (e.g., 3D animation, film noir, watercolor painting, photorealistic, 1990s product photography).

- Editing Instructions: For modifying an existing image, be direct and specific. (e.g., change the man’s tie to green, remove the car in the background).

Example prompt:

A photorealistic close-up portrait of an elderly Japanese ceramicist with deep, sun-etched wrinkles and a warm, knowing smile. He is carefully inspecting a freshly glazed tea bowl. The setting is his rustic, sun-drenched workshop. The scene is illuminated by soft, golden hour light streaming through a window, highlighting the fine texture of the clay. Captured with an 85mm portrait lens, resulting in a soft, blurred background (bokeh). The overall mood is serene and masterful. Vertical portrait orientation.

Promptologie n°5 : Créer une image

Exactement ce que je voulais ^^

Une image de trump, la bouche ouverte en rond. il nous regarde de face, photo en plan poitrine. La peau de son visage est comme une peau orange photo réaliste : une texture de peau d'oranges. Il n'a pas de cheveux. Le haut de sa tête est comme le haut de l'orange, avec la queue d'orange qui dépasse en l'air

J’ai mis ma description dans DeepSeek, il la reformulé, puis je l’ai remise dans Grok et ChatGPT…

Hyper-realistic portrait of Donald Trump, mouth open in a perfect 'O' shape, looking directly at the camera. His skin has the exact texture of an orange peel: bumpy, shiny, and bright orange. He is completely bald, and the top of his head resembles the stem end of an orange, with a small green orange stem sticking straight up. The lighting is dramatic, highlighting the citrus-like texture. The background is neutral. The style is surreal but photorealistic, blending humor and artistic precision.

C’est ici pour s’amuser 😁

Promptologie n°6 : Créer son avatar

Un prompt qui marche avec Google NanoBananan Perplexity et d’autres…

A professional, high-resolution, profile photo, maintaining the exact facial structure, identity, and key features of the person in the input image. The subject is framed from the chest up, with ample headroom and negative space above their head, ensuring the top of their head is not cropped. The person looks directly at the camera, and the subject's body is also directly facing the camera. They are styled for professional photo studio shoot, wearing a smart casual lazer. The background is a solid '#141414' neutral studio. Shot from a high angle with bright and airy soft, diffused studio lighting, gently illuminating the face and creating a subtle catchlight in the eyes, conveying a sense of clarity. Captured on an 85mm f/1.8 lens with a shallow depth of field, exquisite focus on the eyes, and beautiful, soft bokeh. Observe crisp detail on the fabric texture of the blazer, individual strands of hair, and natural, realistic skin texture. The atmosphere exudes confidence, professionalism, and approachability. Clean and bright cinematic color grading with subtle warmth and balanced tones, ensuring a polished and contemporary feel.

J’ai ma photo d’origine (1), PerplexityAI (2), NanoBanana (3)

Promptologie n°7 : Analyser un PDF

- J’ai téléversé ce PDF. Donnez-moi une vue d’ensemble de haut niveau du document, divisée en thèmes et concepts clés, comme si vous le présentiez à quelqu’un qui le découvre pour la première fois.

- Enseignez le contenu de ce document étape par étape, en partant des bases et en augmentant progressivement la difficulté. Supposons que j’apprenne ce sujet pour la première fois.

- Transformez chaque section ou chapitre de ce document en une courte leçon avec une explication claire, des exemples et un résumé rapide à la fin.

- Identifiez les parties les plus complexes ou déroutantes de ce document et expliquez-les en langage simple en utilisant des analogies ou des exemples concrets.

- Extrayez tous les concepts importants, termes et définitions de ce document et expliquez chacun d’eux clairement, comme s’il fallait les retenir pour un examen.

- Créez des questions d’entraînement à partir de ce document pour tester ma compréhension. Posez-moi d’abord les questions, puis expliquez les réponses correctes après coup.

- Transformez les idées principales de ce document en schémas structurés ou modèles mentaux qui m’aident à voir comment tout se connecte.

- Réécrivez ce document sous forme de notes d’étude concises optimisées pour une révision rapide, en ne surlignant que l’essentiel.

- Imagine que je viens de l’étudier. Posez-moi des questions et vérifiez mes réponses. S’il y a des erreurs ou des points peu clairs, corrigez-moi et expliquez ce que j’ai raté.

Make.com, pour automatiser

Pour automatiser de nombreux prompts : Make.com

- Réécriture automatique fiches produits – WooCommerce & Shopify

https://www.youtube.com/watch?v=XFP5fgM00jY - Automatiser Fiches Produits PRESTASHOP avec chatGPT

https://www.youtube.com/watch?v=Yypbwh69KZ8 - Connecter l’API de FLUX AI sur Make en 5 minutes !

https://www.youtube.com/watch?v=IEaq-iRnYcw - Des automatisations personnalisées avec Make

https://www.leroynicolas.fr/ - Mes automatisations Make en quelques minutes

https://formations.leroynicolas.fr/

Pour l’automatisation il y a aussi N8N.io

- Ex : « DeepSeek V3 Chat & R1 Reasoning Quick Start »

https://n8n.io/workflows/2777-deepseek-v3-chat-and-r1-reasoning-quick-start/

Pour envoyer des data à l'IA....

- Souvent le PDF (bien formaté) fonctionne bien…

- Pour les images avec du texte, c’est mieux de faire des OCR avant…

- Pour les autres types de document (Word, Excel, etc…) ca peut etre bien de les convertir directement vers du markdown ! (un format texte avec un peu de mise en page)

Tu peux essayer ce service pour tes .doc .docx .xls ,etc….

https://mconverter.eu/convert/markdown/

Ensuite tu récupère le fichier Markdown : monfichier.md …. et tu le donne a GPT, il va adorer…

Pour extraire les data d'un site....

Empower your AI apps with clean data from any website. Featuring advanced scraping, crawling, and data extraction capabilities.

- Scrape: scrapes a URL and get its content in LLM-ready format (markdown, structured data via LLM Extract, screenshot, html)

- Crawl: scrapes all the URLs of a web page and return content in LLM-ready format

- Map: input a website and get all the website urls – extremely fast

- Search: search the web and get full content from results

- Extract: get structured data from single page, multiple pages or entire websites with AI.

- LLM-ready formats: markdown, structured data, screenshot, HTML, links, metadata

Pour coder avec l'IA....

Visual Studio :

Avec Visual Studio, vous pouvez coder avec une IA qui prend en contexte l’ensemble de votre base de code.

Cursor :

Built to make you extraordinarily productive, Cursor is the best way to code with AI.

AI Agents : Awesome LLM Apps

Source : https://github.com/Shubhamsaboo/awesome-llm-apps

A curated collection of Awesome LLM apps built with RAG, AI Agents, Multi-agent Teams, MCP, Voice Agents, and more. This repository features LLM apps that use models from OpenAI, Anthropic, Google, and open-source models like DeepSeek, Qwen or Llama that you can run locally on your computer.

Starter AI Agents

- AI Blog to Podcast Agent

- AI Breakup Recovery Agent

- AI Data Analysis Agent

- AI Medical Imaging Agent

- AI Meme Generator Agent (Browser)

- AI Music Generator Agent

- AI Travel Agent (Local & Cloud)

- Gemini Multimodal Agent

- Local News Agent (OpenAI Swarm)

- Mixture of Agents

- xAI Finance Agent

- OpenAI Research Agent

- Web Scrapping AI Agent (Local & Cloud)

List of Free GenAI Courses

Source : https://github.com/aishwaryanr/awesome-generative-ai-guide

LLM Basics and Foundations

Large Language Models by ETH Zurich

Understanding Large Language Models by Princeton

Transformers course by Huggingface

NLP course by Huggingface

CS324 – Large Language Models by Stanford

Generative AI with Large Language Models by Coursera

Introduction to Generative AI by Coursera

Generative AI Fundamentals by Google Cloud

5-Day Gen AI Intensive Course by Google & Kaggle

Introduction to Large Language Models by Google Cloud

Introduction to Generative AI by Google Cloud

Generative AI Concepts by DataCamp (Daniel Tedesco Data Lead @ Google)

1 Hour Introduction to LLM (Large Language Models) by WeCloudData

LLM Foundation Models from the Ground Up | Primer by Databricks

Generative AI Explained by Nvidia

Transformer Models and BERT Model by Google Cloud

Introduction to Responsible AI by Google Cloud

Fundamentals of Generative AI by Microsoft Azure

Generative AI for Beginners by Microsoft

ChatGPT for Beginners: The Ultimate Use Cases for Everyone by Udemy

[1hr Talk] Intro to Large Language Models by Andrej Karpathy

ChatGPT for Everyone by Learn Prompting

Large Language Models (LLMs) (In English) by Kshitiz Verma (JK Lakshmipat University, Jaipur, India)

Generative AI for Beginners By CodeKidz, based on Microsoft’s open sourced course.

Building LLM Applications

LLMOps: Building Real-World Applications With Large Language Models by Udacity

Full Stack LLM Bootcamp by FSDL

Generative AI for beginners by Microsoft

Large Language Models: Application through Production by Databricks

Generative AI Foundations by AWS

LLM University by Cohere

LLM Learning Lab by Lightning AI

LangChain for LLM Application Development by Deeplearning.AI

LLMOps by DeepLearning.AI

Automated Testing for LLMOps by DeepLearning.AI

Building Generative AI Applications Using Amazon Bedrock by AWS

Efficiently Serving LLMs by DeepLearning.AI

Building Systems with the ChatGPT API by DeepLearning.AI

Serverless LLM apps with Amazon Bedrock by DeepLearning.AI

Building Applications with Vector Databases by DeepLearning.AI

Automated Testing for LLMOps by DeepLearning.AI

Build LLM Apps with LangChain.js by DeepLearning.AI

Advanced Retrieval for AI with Chroma by DeepLearning.AI

Operationalizing LLMs on Azure by Coursera

Generative AI Full Course – Gemini Pro, OpenAI, Llama, Langchain, Pinecone, Vector Databases & More by freeCodeCamp.org

Training & Fine-Tuning LLMs for Production by Activeloop

Prompt Engineering, RAG and Fine-Tuning

LangChain & Vector Databases in Production by Activeloop

Reinforcement Learning from Human Feedback by DeepLearning.AI

Building Applications with Vector Databases by DeepLearning.AI

Finetuning Large Language Models by Deeplearning.AI

LangChain: Chat with Your Data by Deeplearning.AI

Building Systems with the ChatGPT API by Deeplearning.AI

Prompt Engineering with Llama 2 by Deeplearning.AI

Building Applications with Vector Databases by Deeplearning.AI

ChatGPT Prompt Engineering for Developers by Deeplearning.AI

Advanced RAG Orchestration series by LlamaIndex

Prompt Engineering Specialization by Coursera

Augment your LLM Using Retrieval Augmented Generation by Nvidia

Knowledge Graphs for RAG by Deeplearning.AI

Open Source Models with Hugging Face by Deeplearning.AI

Vector Databases: from Embeddings to Applications by Deeplearning.AI

Understanding and Applying Text Embeddings by Deeplearning.AI

JavaScript RAG Web Apps with LlamaIndex by Deeplearning.AI

Quantization Fundamentals with Hugging Face by Deeplearning.AI

Preprocessing Unstructured Data for LLM Applications by Deeplearning.AI

Retrieval Augmented Generation for Production with LangChain & LlamaIndex by Activeloop

Quantization in Depth by Deeplearning.AI

Evaluation

- Building and Evaluating Advanced RAG Applications by DeepLearning.AI

- Evaluating and Debugging Generative AI Models Using Weights and Biases by Deeplearning.AI

- Quality and Safety for LLM Applications by Deeplearning.AI

- Red Teaming LLM Applications by Deeplearning.AI

Multimodal

- How Diffusion Models Work by DeepLearning.AI

- How to Use Midjourney, AI Art and ChatGPT to Create an Amazing Website by Brad Hussey

- Build AI Apps with ChatGPT, DALL-E and GPT-4 by Scrimba

- 11-777: Multimodal Machine Learning by Carnegie Mellon University

- Prompt Engineering for Vision Models by Deeplearning.AI

Agents

- Building RAG Agents with LLMs by Nvidia

- Functions, Tools and Agents with LangChain by Deeplearning.AI

- AI Agents in LangGraph by Deeplearning.AI

- AI Agentic Design Patterns with AutoGen by Deeplearning.AI

- Multi AI Agent Systems with crewAI by Deeplearning.AI

- Building Agentic RAG with LlamaIndex by Deeplearning.AI

- LLM Observability: Agents, Tools, and Chains by Arize AI

- Building Agentic RAG with LlamaIndex by Deeplearning.AI

- Agents Tools & Function Calling with Amazon Bedrock (How-to) by AWS Developers

- ChatGPT & Zapier: Agentic AI for Everyone by Coursera

- Multi-Agent Systems with AutoGen by Victor Dibia [Book]

- Large Language Model Agents MOOC, Fall 2024 by Dawn Song & Xinyun Chen – A comprehensive course covering foundational and advanced topics on LLM agents.

- CS294/194-196 Large Language Model Agents by UC Berkeley

Miscellaneous

- Avoiding AI Harm by Coursera

- Developing AI Policy by Coursera

Resources

Conclusion

En fin de compte, l’art du prompt est comme une danse avec l’intelligence artificielle – nous guidons, elle suit, parfois elle nous surprend avec un pas impromptu. Entre Claude qui raisonne, GPT-4o qui voit tout, et Make qui automatise, nous sommes passés de simples utilisateurs à véritables chorégraphes numériques. La promptologie n’est pas qu’une technique, c’est une philosophie : celle où l’humain et la machine co-créent un futur où la technologie amplifie notre créativité plutôt que de la remplacer.

Alors, prêt à devenir promptologue de votre vie numérique ? Comme dirait un développeur perdu dans ses tokens: « La réponse est dans la question… il suffit juste de bien la formuler ! »

Interrogations philosophiques

sur l’émergence d’une IA superintelligente

Julien Guézennec

Julien Guézennec est un développeur web full stack senior basé à Pantin (93), créateur du studio julienweb.fr. Expert en conception digitale depuis 1998, il accompagne entreprises, startups et indépendants dans la création de sites web sur-mesure, performants, responsives et orientés UX. Il maîtrise l'ensemble de la chaîne web : développement front et back-end, WordPress, SEO, accessibilité, design UI, datavisualisation, IA et web 3D. Ancien ingénieur innovation chez Bouygues Telecom, Julien est aussi formateur, consultant et passionné par la transmission des savoirs. Il intervient sur des projets variés : e-commerce, web apps, interfaces d’administration, plugins, contenus pédagogiques, mailing, sécurité et plus encore. Disponible à distance ou en présentiel (Paris / Île-de-France) Contact : julien.guezennec@gmail.com Page de profil : Julien Guézennec, c'est qui ?